اکونومیست مطرح کرد

نحوه عملکرد نورونها در حال روشن شدن است

پیچیدگی نورون و اجزای سازنده آن توجه دانشمندان رایانه را به خود جلب کرده است. در اوایل دهه ۲۰۱۰ میلادی شبکههای عصبی عمیق چنان پیشرفتهای چشمگیری در تواناییهای هوش مصنوعی ایجاد کردند که این نگرانی واقعی وجود داشت که مردم به زودی مجبور شوند با ماشینهایی باهوشتر از آن دست و پنجه نرم کنند.

فرارو- روشن شدن نحوه عملکرد نورونها هم به پزشکی و هم به جستجوی هوش مصنوعی بهتر کمک میکند.

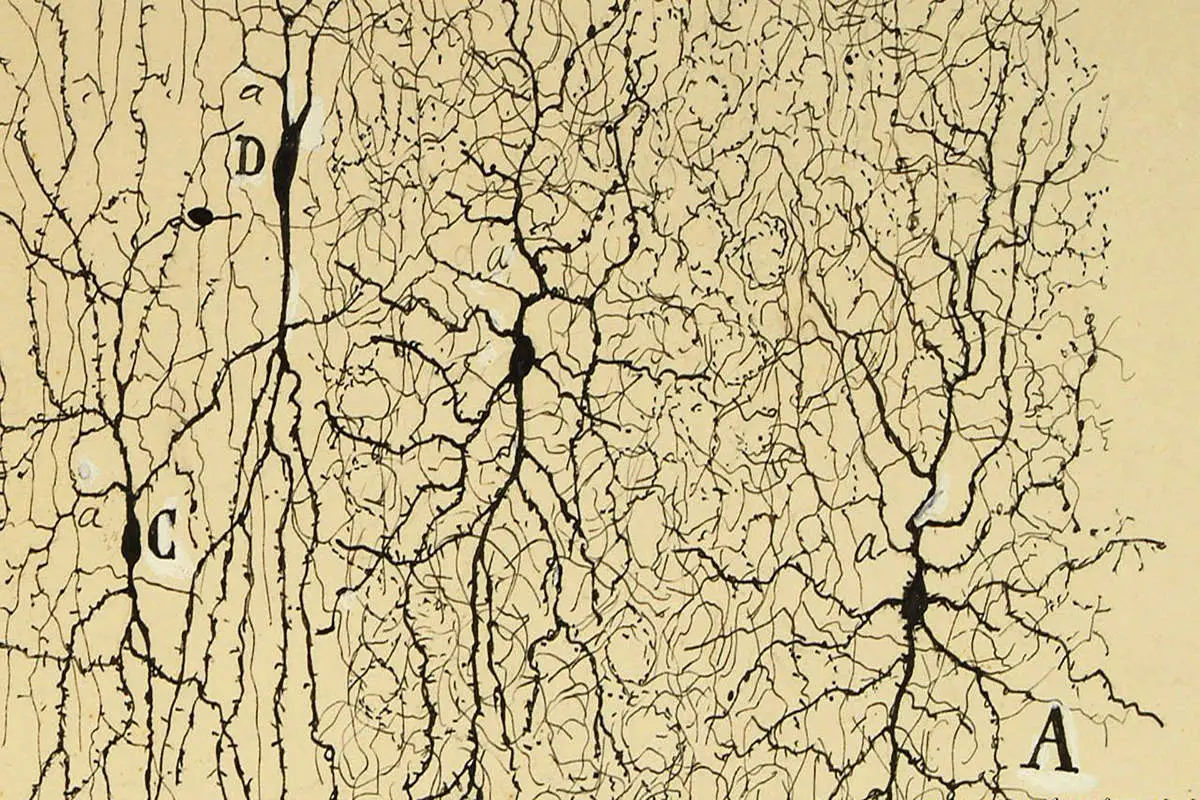

به گزارش فرارو به نقل از اکونومیست، نورون زیباست. از زمانی که «سانتیاگو رامون ئی کاخال» زیستشناس اسپانیایی و متخصص بافتشناسی آن را به نیترات آغشته کرد تا زیر میکروسکوپ دهه ۱۸۸۰ میلادی قابل مشاهده باشد انشعابات آن تخیل علمی را برانگیخت. رامون نورونها را «پروانههای روح» نامید.

آن انشعابات دندریتها را برای جمع آوری سیگنالهای دریافتی به نام پتانسیل عمل از نورونهای دیگر و یک آکسون منفرد برای انتقال مجموع آن سیگنالها در قالب یک پتانسیل عمل دیگر نورونها را به بخشهایی از ساختارهای بسیار بزرگتر تبدیل میکنند.

به عنوان شبکههای عصبی، مهندسان اکنون از شبیه سازیها برای ایجاد چیزی استفاده میکنند که از آن تحت عنوان هوش مصنوعی یاد شده اگرچه این یک سایه کم رنگ از موضوع واقعی است.

این که چگونه نورونها واقعا جادوی خود را به کار میبرند اکنون از هم گسیخته شده است. یک نتیجه این است که هر یک به تنهایی به اندازه یک شبکه عصبی مصنوعی با اندازه مناسب یک پردازشگر اطلاعات قدرتمند هستند. این امر نه تنها برای یادگیری نحوه عملکرد مغزها و نحوه اشتباه آن بلکه برای طراحی نسخههای مصنوعی که شباهت بیشتری به نوع طبیعی دارند نیز دارد کارآمد است.

اولین مدل نورونی که به طور گسترده پذیرفته شد در سال ۱۹۵۷ میلادی توسط «فرانک روزنبلات» روانشناس آمریکایی (که به نوبه خود از «آلن تورینگ» پیشگام محاسبات بریتانیایی اقتباس کرد) به شکل موجود خود پیشنهاد شد «پرسپترون» بود. پرسپترون یک الگوریتم یادگیری ماشین است که در دسته یادگیری با نظارت قرار میگیرد.

الگوریتم پرسپترون یک الگوریتم دستهبندی دودویی (نوعی از دسته بندی که میتواند با توجه به بردار ورودی تصمیم بگیرد که این ورودی متعلق به یک کلاس است یا خیر) میباشد. این الگوریتم یک دسته بند خطی است به این معنا که پیش بینیهایش را با توجه به ترکیب خطی وزن دار ورودی الگوریتم انجام میدهد. هم چنین، این الگوریتم به دلیل این که ورودیهایش را به صورت تک تک در زمان بررسی میکند یک الگوریتم برخط میباشد.

این الگو یک تابع ریاضی است که مجموعهای از ارقام باینری (صفر و یک) را به عنوان ورودی دریافت میکند، آنها را در «وزن» عددی ضرب مینماید و سپس محصولات را با هم جمع میکند. اگر نتیجه از یک مقدار از پیش تعیین شده بیشتر شود پرسپترون یک «یک» را بیرون میاندازد و اگر نتیجه از مقدار از پیش تعیین شده بیشتر نشود یک «صفر» را بیرون میزند.

کیک لایهای

برای ساخت شبکههای عصبی مصنوعی پرسپترونها به صورت نرم افزاری کدگذاری میشوند. پرسپترونها از نظر منطقی در لایههای به هم پیوسته سازماندهی میشوند و نتیجه برای حل مشکلات از طریق بازخورد و حلقههای بازخورد بین لایهها آموزش داده میشود. این حلقهها مقادیر وزنها و در نتیجه رفتار شبکه را تغییر میدهند. هر چه تعداد لایهها بیشتر باشد شبکه «عمیق تر» است.

شبکههای عصبی عمیق اکنون زیربنای همه چیز از گوگل ترنسلیت گرفته تا Siri (یک دستیار شخصی هوشمند و راهنمای مجهز به هوش مصنوعی است که در آی او اس (سیستم عامل گوشیهای تلفن همراه و آیپدهای اپل یا آیفون وجود دارد) اپل هستند.

همه شبکههای عصبی تقلید میکنند که چگونه پتانسیلهای عملی که به اتصالات سیناپسی بین آکسونها و دندریتها میرسند که از طریق آن نورونها با هم ارتباط برقرار میکنند سیگنالهایی را ایجاد کنند که سپس با یکدیگر ترکیب میشوند تا پتانسیلهای عمل جدیدی را در آکسون سلول گیرنده ایجاد نمایند یا خیر. بنابراین، دیدن نورونها به عنوان پرسپترونهای فیزیکی وسوسهانگیز است با این تفاوت که سیگنالهای آن توسط یونهای سدیم، پتاسیم و کلسیم که از غشاهای سلولی عبور میکنند به جای جریان الکترونها منتقل میشوند. برای چندین دهه، تعداد زیادی از عصبشناسان آن را مشاهده کردند.

با این وجود، در اوایل دهه ۲۰۰۰ میلادی «پانایوتا پویرازی» از مؤسسه بیولوژی مولکولی و بیوتکنولوژی در هراکلیون در یونان نگاهی متفاوت به این موضوع را آغاز کرد. او نورونها را به عنوان شبکههای پرسپترون تصور میکرد. در سال ۲۰۰۳ میلادی او استدلال کرد که یک شبکه دو لایه ساده ممکن است برای مدلسازی آنان کافی باشد. در سال ۲۰۲۱ میلادی، «دیوید بنیاگوف» از دانشگاه عبری اورشلیم به این نتیجه رسید که برای نورونهای قشر مغز انسان دست کم به پنج لایه (و گاهی حتی به هشت) لایه نیاز است که هر کدام تا ۲۵۶ پرسپترون دارند.

این بدان معناست که محاسبات زیادی باید در درون نورونهای فردی انجام شود. امروزه دندریتها بهعنوان پتانسیلهای عملی کوچک به نام خوشههای دندریتیک شناخته میشوند و انواع مختلفی دارند: سنبلههای کلسیم (طولانی و آهسته)، سنبلههای سدیم (کوتاه و سریع) و سنبلههای nmda (که توسط یک ماده شیمیایی به نام ان - متیل - دی - آسپارتات تحریک میشود). این سنبلهها با هم به دندریتها اجازه دادند ۱۵ عمل از ۱۶ عملیات اساسی جبر بولی را انجام دهند شاخهای از ریاضیات که اساس محاسبات دیجیتالی است. این عملیات دو مقدار ورودی را با هم مقایسه میکند و در نتیجه یک سوم را بیرون میاندازند. برخی مانند و، یا، نه و نه، خود توضیحی هستند و برخی دیگر مانند nand، xnor و xor کمتر قابلیت خود توضیحی دارند.

در این میان xor به طور خاص بدنام است تنها زمانی خروجی غیر صفر میدهد که ورودیهای آن متفاوت باشند. در سال ۱۹۶۹ میلادی دو دانشمند برجسته رایانه به نامهای «ماروین مینسکی» و سیمور پیپرت" ثابت کردند که xor را نمیتوان با یک پرسپترون انجام داد یکی از تنها دو عملیات بولی که در مورد آن صادق است. این نتیجه تحقیقات هوش مصنوعی را برای یک دهه متوقف کرد.

تصور میشد که این موضوع در مورد دندریتها نیز صدق میکند. با این وجود، در سال ۲۰۲۰ میلادی کار «آلبرت گیدون» از دانشگاه هومبولت در برلین که دکتر پویرازی نیز در آن مشارکت داشت دسته جدیدی از سنبلههای مبتنی بر کلسیم را پیدا کرد که به xor اجازه فعالیت میدهد. بنابراین، این که یک دندریت منفرد میتواند عملکرد بهتری از پرسپترون داشته باشد نشان میدهد که یک لایه کامل از محاسبات پیچیده دور از دید مدلهای معمولی نورونها در حال انجام است. این ممکن است به توضیح عملکرد قابل توجه مغزها و شکست هوش مصنوعی در بازتولید آن کمک کند.

آکسونها نیز مورد ارزیابی مجدد قرار گرفته اند. پتانسیلهای عملی که آنها حمل میکنند زمانی توسط بسیاری مشابه همه یا هیچی بودن یک رقم باینری دیده میشد. با این وجود، با دقت نگاه کنید چرا که پتانسیلهای عمل هم از نظر ارتفاع و هم در عرض متفاوت هستند. این نکته مهمی است.

در سال ۲۰۱۶ میلادی گروهی از موسسه علوم اعصاب ماکس پلانک در فلوریدا (یکی از معدود شعب آن مرکز در خارج از سرزمین آلمانی آن) نشان دادند که نورونهای سیستم عصبی مرکزی به طور فعال وسعت پتانسیلهای عمل خود را تنظیم میکنند. سال بعد، تیمی از کالج دارتموث در نیوهمپشایر کشف کردند نورونهایی که در قشر مغز قرار دارند به طور فعال قد و اندازه خود را نیز تنظیم میکنند.

حتی طول فواصل بین پتانسیلهای عمل نیز اهمیت دارد. در مه ۲۰۲۱ میلادی «سلمان قاسم» از دانشگاه کلمبیا گزارش داد که نورونهای هیپوکامپ بخشی از مغز که در شکل گیری حافظه نقش دارد زمان شلیک خود را تعدیل میکنند تا اطلاعات مربوط به حرکت بدن در فضا را رمزگذاری کنند. در آگوست همان سال «لیلا ردی» و «متیو سلف» از دانشگاه تولوز در فرانسه گزارش دادند که نورونها نیز این کار را برای رمزگذاری ترتیب رویدادها در خاطرات انجام میدهند.

همه این موارد پیامدهای بالینی دارند. به طور خاص، شواهد فزایندهای وجود دارند که نشان میدهند رشد دندریت غیر معمول در دوران کودکی و اوایل بزرگسالی با اوتیسم، اسکیزوفرنی و صرع مرتبط هستند. در همین حال، بدتر شدن عملکرد آکسون به طور مشابه با روانپریشی در مولتیپل اسکلروزیس (ام اس)، اسکیزوفرنی و اختلال دوقطبی همراه است. این اکتشافات از توسعه داروهای جدید خبر میدهند. به عنوان مثال، کتامین که باعث ایجاد تغییرات ساختاری طولانی مدت در دندریتها میشود به عنوان درمانی برای افسردگی مورد توجه قرار گرفته است.

هنر فراموش کردن

پیچیدگی نورون و اجزای سازنده آن نیز توجه دانشمندان رایانه را به خود جلب کرده است. در اوایل دهه ۲۰۱۰ میلادی شبکههای عصبی عمیق چنان پیشرفتهای چشمگیری در تواناییهای هوش مصنوعی ایجاد کردند که این نگرانی واقعی وجود داشت که مردم به زودی مجبور شوند با ماشینهایی باهوشتر از آن دست و پنجه نرم کنند. سپس ناگهان پیشرفت متوقف شد.

شبکههای عصبی عمیق به سه مانع برخورد کرده اند. ابتدا دانشمندان رایانه دریافتند هنگامی که یک شبکه یک کار را یاد میگیرد برای انتقال آن مهارتها به مهارت جدید هرچند مشابه بدون بازآموزی گسترده تلاش میکند. دوم هنگامی که چنین شبکهای دوباره آموزش داده میشود تمایل دارد که نحوه انجام وظیفه اصلی را فراموش کند این اثر فراموشی فاجعهآمیز نامیده میشود. سوم برای آموزش یک شبکه بزرگ به حجم عظیمی از دادهها دسترسی به ابررایانهها و مگاوات برق مورد نیاز برای راه اندازی این ابررایانهها برای روزها (یا حتی هفته ها) در یک زمان نیاز است.

مغز با هیچ یک از این موارد مبارزه نمیکند. بدون زحمت دانش را بین دامنهها منتقل میکند در ادغام مهارتهای قدیمی و جدید مشکلی ندارد و به طور قابل توجهی کارآمد است با وات کار میکند و نه با مگاوات. پیچیدگی نورونها ممکن است تفاوت ایجاد کند. در مطالعاتی که نتیجه آن سال گذشته منتشر شد تیمی از Numenta یک شرکت تحقیقاتی کالیفرنیایی نورونهای مصنوعی را با اجزای فرعی دندریت مانند طراحی کردند که در برابر فراموشی فاجعه بار مصون هستند.

شبکهای از این نورونها که روی ۱۰۰ کار به صورت متوالی آموزش دیده بودند توانایی انجام همه کارها را با دقت معقول حفظ کردند. همین شبکه هم چنین در یادگیری همزمان بسیاری از کارها از شبکههای پرسپترون بهتر عمل میکند.

نتیجه چندین مطالعه نشان میدهند که نورونهای مصنوعی پیچیده میتوانند عملکردهای پیچیدهای (برای مثال xor) را با دقت بیشتر و انرژی کمتری نسبت به پرسپترونها انجام دهند. با اتصال به شبکه، چنین دستگاههایی سریعتر و با هزینه محاسباتی کمتری نسبت به پرسپترونها یاد میگیرند. این پرسش که مغزها چگونه دانش را از یک حوزه به حوزههای دیگر اعمال میکنند یک راز باقی مانده است. با این وجود، اگر پیچیدگی نورونها نیز این موضوع را توضیح دهد تعجبآور نخواهد بود.

پس این درس آشناست: طبیعت ابتدا به آنجا رسید. شاید ضرورت مادر اختراع باشد، اما انتخاب طبیعی مادر مخترعان است. هم در علوم اعصاب و هم در هوش مصنوعی دهه آینده نویدبخش است. بیش از یک قرن پس از توصیف آن پروانههای رامون ئی کاخال در حال پرواز هستند.