کلان دادهها (Big Data) چیست و چه اهمیتی دارد؟

Big Data (کلان دادهها) چیست و در چه حوزههایی کاربرد دارد؟

مساله کلانداده (Big Data)به مجموعه دادههای بزرگ و پیچیدهای باز میگردد که پردازش آنها با استفاده از سیستمهای پایگاه داده یا نرمافزارهای پردازش داده سنتی کاری دشوار است. نخستین هدف تحلیلهای کلان داده پردازش حجم عظیم، با نرخ رشد بالا، متنوع و همراه با صحت دادهها با بهرهگیری از روشهای هوشمند محاسباتی و سنتی متعدد است. این امر به تصمیمسازی ارتقا یافته، کشف بینش و بهینهسازی در عین نوآوری و مقرون به صرفه بودن کمک میکند

از این گفته به خوبی پیداست که ما تا چه حجم داده را در روز میتوانیم تولید کنیم، اما نگرانی در این خصوص نیست و کامپیوترهای شخصی، توانایی مدیریت این حجم از اطلاعات را برای ما دارند. البته نکته اصلی آن جاست که برای ذخیره همه این اطلاعات تنها به یک هارد دیسک مناسب نیاز است. اما در سطح کلان این دادههای تولید بشر وقتی در کنار یک دیگر قرار میگیرد حجم غیر قابل باروی را به وجود میآورند که مدیریت آن با سیستمهای سنتی کنترل دادهها ممکن نیست.

برای روشن شدن موضوع به چند مثال در این خصوص اشاره میکنیم؛ حجم اطلاعاتی که تا سال ۲۰۰۳ توسط انسان ایجاد شد، تنها ۵ اگزابایت است؛ اما امروزه این حجم از اطلاعات، تنها در عرض دو روز ایجاد میشود. IBM در تحقیقی نشان داد هر روز ۵/۲ اگزابایت داده تولید میشود که حدود %۹۰ دادههای موجود، فقط در دو سال اخیر تولید شده است. شرکتی مانند گوگل، بیلیونها سِروِر در سطح جهان دارد. حدود ۶ بیلیون مشترک تلفن همراه در جهان همه روزه ۱۰ میلیون پیام متنی ارسال و دریافت میکنند و تا سال ۲۰۲۰ حدود ۵۰ بیلیون وسیله متصل به اینترنت و شبکه وجود خواهد داشت.

تعریف کلان دادهها (Big Data)

در واقع همین حجم غیر قابل تصور دادهها است که به کلان داده ها، دادههای حجیم یا بزرگ دادهها (Big data) معروف شده است. نکته قابل توجه آن است که کلانداده ترجمه متداول و پرکاربرد عبارت Big Data محسوب میشود، در حالیکه معادل فارسی برگزیده شده توسط فرهنگستان زبان و ادب پارسی «مِهداده» است.

با این همه برای دادههای کلان، تعاریف مختلفی ارائه شده است. دادههای کلان را میتوان دادههایی که پردازش آنها خارج از حدّ توان سیستمهای کنونی است، تعریف نمود و یا دادههای کلان را افزایش حجم داده دانست؛ به گونهای که ذخیره، پردازش و آنالیز آن از طریق فناوریهای قدیمی دیتابیسها به سختی ممکن باشد. به زبان ساده مقیاس این کلان دادهها به قدری بزرگ است که ابزارهای سنتی ذخیره سازی و تجزیه و تحلیل دادهها قادر به کارکردن با آنها نیستند.

به طور کلی، مساله کلانداده به مجموعه دادههای بزرگ و پیچیدهای باز میگردد که پردازش آنها با استفاده از سیستمهای پایگاه داده یا نرمافزارهای پردازش داده سنتی کاری دشوار است. این دادهها در قالبهای «ساختار یافته» (structured)، «ساختار نیافته» (unstructured) و «نیمه ساختار یافته» (semi-structured) در اندازه پتابایت (PB)، اگزابایت (EB)، زتابایت (ZB) و حتی بیشتر وجود دارند.

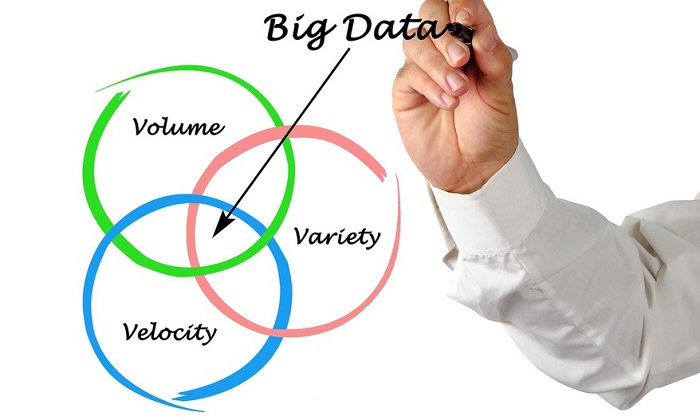

کلاندادهها را به طور رسمی با سه یا چهار کلمه که در انگلیسی با حرف «V» آغاز میشوند تعریف میکنند. سه V. به «حجم» (volume)، «سرعت» (velocity) و «تنوع» (variety) اشاره دارد. در تعریف چهار V، ویژگی چهارم «صحت» (veracity) است که شامل دسترسیپذیری و پاسخگو بودن میشود. البته توسعه این عناوین همچنان ادامه داشت و بالغ بر یک دهه بعد چهار V، سپس هفت V. و در ادامه یازده V. معرفی شدند. (منظور آن دسته از واژگانی است که در انگلیسی با حرف V. آغاز میشوند و از جمله خصوصیات کلانداده محسوب میشوند.)

تاریخچه کلان دادهها (Big Data)

دغدغه حجم کلان دادههای تولید بشر به طور جدی از دهههای ۶۰ و ۷۰ میلادی آغاز شد با این همه اصطلاح دادههای کلان (Big Data)، مفهمومی امروزی و جدید است. در سال ۱۹۹۷ دیوید اِیسورت در مقالهای بیان کرد که چالشهایی برای سیستم کامپیوتری وجود دارد و آن هم وجود مجموعه دادههای بسیار بزرگ است که بر روی حافظههای معمولی قابل ذخیره سازی نیست. این مجموعه، داده بزرگ (Big Data) نام گرفت و اصطلاح Big Data یا همان دادههای بزرگ برای اولین بار در کتابخانه دیجیتال ACM تعریف و بکار گرفته شد.

در سال ۲۰۰۰ مطالعه جامعی بر روی تعیین کمیت داده در شرایط ذخیره سازی انجام شد. دادههایی که در سالهای قبل تولید شده و به حد ۱.۵ اگزابایت رسیده بودند، در فضای بزرگی مانند رسانههای ذخیره سازی مغناطیسی ثبت و نگهداری شده اند. سال ۲۰۰۵ تیم اوریِلی، در مقاله «وب ۲.۰ چیست»، بیان کرد: پایگاه دادهای باید وجود داشته باشد تا تمامی اطلاعات را در خود قرار داده، سپس آنها را مدیریت کند و ما آنها را به عنوان افزار اطلاعاتی و نه به عنوان یک نرم افزار، بشناسیم.

جنبههای کلان دادهها(Big Data)

پیش از این اشاره شد که کلاندادهها را به طور رسمی با سه یا چهار کلمه یا جنبه که در انگلیسی با حرف «V» آغاز میشوند تعریف میشوند و برای کار کردن با کلان داده ها، همواره نیازمند توجه به این جنبهها هستیم.

حجم دادهها (Volume): با بیگ دیتا شما با حجم زیادی از دادههای بدون ساختار و با تراکم پایین مواجه هستید. این دادهها میتوانند شامل دادههایی با مقادیر نامعلوم مثل دادههای توییتر، کلیکهای مربوط به یک صفحه وب یا دادههای مربوط به یک حسگر باشد. برای برخی سازمانها این به معنی دهها ترابایت داده است.

سرعت (Velocity): سرعت به نرخ دریافت و همچنین در برخی موارد انجام اعمالی بر روی دادهها اطلاق میشود. برای مثال برخی از ابزار هوشمند مبتنی بر اینترنت نیاز به دریافت اطلاعات به صورت بلادرنگ و البته انجام پردازشها به صورت بلادرنگ دارند.

تنوع (Variety): این جنبه به انواع دادههایی که در بیگ دیتا مورد استفاده قرار میگیرند اشاره دارد. دادههای سنتی اغلب ساختار یافته بودند و در پایگاه دادهای رابطهای ذخیره میشدند. اما با ظهور بیگ دیتا، دادهها بدون ساختار شدند. دادههایی مثل صدا، متن و تصویر که به پردازشهای تکمیلی جهت برداشت معانی خاص از آنها نیازمند هستیم. علاوه بر این، ارزش و اعتبار دادهها نیز طی سالیان گذشته مورد توجه قرار گرفته است.

شیوه کار کلان دادهها(Big Data)

نخستین هدف تحلیلهای کلان داده پردازش حجم عظیم، با نرخ رشد بالا، متنوع و همراه با صحت دادهها با بهرهگیری از روشهای هوشمند محاسباتی و سنتی متعدد است. این امر به تصمیمسازی ارتقا یافته، کشف بینش و بهینهسازی در عین نوآوری و مقرون به صرفه بودن کمک میکند. اما بهره مندی از کلان داده در سه مرحله اساسی انجام میشود.

تجمیع و یکپارچگی داده ها: بیگ دیتا دادهها را از منابع مختلفی جمع آوری میکند. مکانیسم تجمیع دادههای سنتی شامل استخراج، انتقال و بارگذاری بود. منتهی برای کار با دادههای عظیم نیاز به استراتژی جدیدی است. در طول تجمیع داده ها، شما نیاز به جمع آوری آن ها، انجام پردازش و اعمال فرمت صحیح به آنها جهت استفاده مناسب برای تجزیه و تحلیل کسب و کار دارید.

مدیریت کلان داده ها: بیگ دیتا نیز به ذخیره سازی نیاز دارد. این کار میتواند در فضای ابری یا فضاهای ذخیره سازی معمول صورت گیرد. شما قادر به ذخیره دادههای خود به هر شکلی خواهید بود. بسیاری از مدیران نحوه ذخیره سازی دادهها را بر اساس مکان تجمیع آنها انتخاب میکنند.

تجزیه و تحلیل داده ها: سرمایه گذاری در حوزه بیگ دیتا زمانی معنا پیدا میکند که با تجزیه و تحلیل آن به دانش مورد نظرتان برسید. استفاده از تجزیه و تحلیلهای گرافیکی به ایجاد دیدی هر چه بهتر از وضع موجود به شما کمک میکند. همچنین با استفاده از این کار میتوانید به توسعه مدلهای دادهای با یادگیری ماشین و هوش مصنوعی بپردازید.

کلان دادهها و هادوپ (Hadoop)

هادوپ یک فریم ورک یا مجموعهای از نرم افزارها و کتابخانههایی است که ساز و کار پردازش حجم عظیمی از دادههای توزیع شده را فراهم میکند. این مجموعه که از سال ۲۰۰۶ راه اندازی شده را میتوان به یک سیستم عامل تشبیه کرد که طراحی شده تا بتواند حجم زیادی از دادهها را بر روی ماشینهای مختلف پردازش و مدیریت کند.

در April سال ۲۰۰۸ هادوپ رکورد جهان را شکست و سریعترین سیستمی شد که توانست ۱ ترابایت داده را ظرف ۲۰۲ ثانیه پردازش کند. در November همان سال گوگل طی گزارشی اعلام کرد که این رکورد را به ۶۸ ثانیه ارتقاء داده است. در April ۲۰۰۹ یاهو اعلام کرد با استفاده از هادوپ توانسته ۱ ترابایت داده را ظرف ۶۲ ثانیه پردازش کند. در سال ۲۰۱۴ نیز یک تیم از شرکت DataBricks اعلام کرد که توانسته حدود ۱۰۰ ترابایت داده را ظرف ۱۴۰۶ ثانیه که تقریبا ۴.۲۷ ترابایت در دقیقه میشود پردازش کند.

امروزه هادوپ بصورت وسیعی و در زمینههای بسیاری از فعالیتهای دانشگاهی تا تجارت، از علوم تا نجوم مورد استفاده قرار میگیرد. هادوپ مکانی امن برای ذخیره و تحلیل دادههای کلان بشمار میرود که مقیاس پذیر، توسعه پذیر و متن باز است. هادوپ هدف اصلی کمپانیهای بزرگ تولید و ذخیره دادهها از جمله Facebook، IBM، EMC، Oracle و Microsoft است.

منابع تولید کلان دادهها(Big Data)

- مدیای اجتماعی: اطلاعاتی است که از طریق به اشتراک گذاری و یا تبادل اطلاعات توسط نشانیهای اینترنتی و یا ارتباطات مجازی و شبکههای مجازی به دست میآیند؛ نظیر اطلاعاتی که در پروژههای اشتراکی، بلاگ ها، میکروبلاگ ها، فیسبوک و توییتر تولید میشوند.

- دادههای ماشین: اطلاعاتی است که به صورت خودکار توسط سخت افزار و نرم افزارهای ابزارهایی نظیر: رایانه ها، وسایل پزشکی یا دیگر ماشینها بدون دخالت انسان تولید میگردد.

- حسگرها: وسایل حسگر مختلفی برای اندازه گیری کمیّتهای فیزیکی و تبدیل آنها به سیگنال وجود دارد که بخشی از دادههای حجیم را تولید مینماید.

- اینترنت اشیاء: IoT، مجموعهای است از اشیاء که به صورت یکتا قابل تعریف هستند و به عنوان بخشی از اینترنت میباشند. این اشیاء، شامل: تلفنهای کوچک، دوربینهای دیجیتال و تبلتها هستند. وقتی این وسایل از طریق اینترنت به یکدیگر متصل میشوند، قادرند بیشتر پردازشهای کوچک و سرویسهای پشتیبانی اقتصادی، محیطی و سلامت را فراهم آورند. تعداد زیاد وسایل متصل به اینترنت، انواع مختلفی از سرویسها را فراهم میآورند و مقادیر زیادی داده و اطلاعات تولید مینمایند.

کاربردهای مهم کلان دادهها(Big Data)

۱ . کاربرد کلان دادهها در سازمانها و شرکتها

کاربرد کلان دادهها در شرکت ها، میتواند بهره وری تولید و رقابت پذیری را از جنبههای بسیاری بالا ببرد. به طور خاص، در بازاریابی، با تحلیل کلان داده ها، شرکتها میتوانند با دقت بیشتری رفتار مشتری را پیش بینی نمایند و شرایط همکاری بهتری را در تجارت پیدا کنند. شرکتها میتوانند در برنامه ریزی و معرفی طرحهای فروش، بعد از مقایسه دادههای حجیم، قیمت کالاهای خودشان را بهینه سازند تا کارآمدی، بهره وری و رضایت بخشی تجاری، بهینه سازی نیروی کار، پیش بینی درست و دقیق تخصیص الزامهای پرسنلی، پرهیز و دوری از ظرفیت تولید اضافی و کاهش هزینه انجام کار را بهبود بخشند. همچنین، این شرکتها میتوانند در زنجیره تأمین نیازهای اساسی خود و با استفاده از دادههای بزرگ، بهینه سازی موجودی انبار و نیازهای ضروری خویش را برای کاهش توقف بین تأمین و تقاضا، کنترل بودجه و بهبود خدمات اداره کنند.

امروزه سازمانها و شرکت ها، از جمله مراکز و سازمانهایی که در زمینه علوم اسلامی فعالیت دارند، میتوانند از دادههای حجیم خود استفادههای گوناگونی ببرند. مرکز تحقیقات کامپیوتری علوم اسلامی، در شمار مراکزی است که بعد از گذشت نزدیک به سه دهه از تحقیقات نرم افزاری خود، حجم عظیمی از دادههای علوم و معارف اسلامی را در اختیار دارد؛ گنجینهای که پاسخگوی نیاز جامعه علمی ایران و دست مایهای بزرگ برای تولید علم در کشور به شمار میرود.

از دیگر کاربردهای کلان داده ها، تولید محصولات نرم افزاری هوشمند است که بر اساس دادههای موجود یا اطلاعات دریافت شده از تعامل با کاربران سامان مییابد؛ برای مثال، وقتی یک محقق علوم اسلامی در جستجوی موضوعی خاص است، دادههای بزرگ در این زمینه او را در دستیابی به مطالب منسجم، جامع و دقیق یاری میرسانند و همه منابع و محتواهای معتبر، میان رشتهای و مرتبط با موضوع را در اختیار او قرار خواهد داد.

۲ . کاربرد کلان دادهها مبتنی بر اینترنت اشیاء (IoT)

برای مثال، کامیونهای UPS به حسگرها، آداپتورهای بی سیم و GPS مجهز هستند که دفتر مرکزی میتواند موقعیتهای کامیون را دنبال کند و از خرابی موتور یا مشکلات احتمالی در طول مسیر جلوگیری نماید. در همین حال، این سیستم به UPS کمک میکند که کارمندانش را نیز مدیریت و نظارت کند و مسیرهای تحویل را بهینه سازد. مسیرهای تحویل بهینه که مختص به کامیونهای UPS است، از سابقه تجربه رانندگی آنها استخراج شده است.

همچنین، شهر هوشمند، یک محدوده پژوهشی بر اساس کاربرد دادههای IoT میباشد؛ برای مثال، همکاری پروژه شهر هوشمند بین Miami-Dade در فلوریدا و IBM نزدیک به ۳۵ نوع دپارتمان دولتی را در آنها به هم متصل میکند و در نتیجه، دولت، میتواند اطلاعات بهتری برای پشتیبانی و تصمیم گیری برای مدیریت منابع آبی، کنترل ترافیک و بهبود امنیت عمومی به دست آورد.

۳ . کاربرد کلان دادهها در شبکههای اجتماعی آنلاین

SNS آنلاین، یک ساختار اجتماعی تشکیل شده از افراد اجتماعی و اتصالات میان افراد بر اساس یک شبکه اطلاعاتی میباشد. دادههای بزرگ SNS آنلاین، از پیامهای فوری و آنلاین، میکروبلاگ و یا فضای اشتراک میباشد که فعالیتهای مختلف کاربر را اداره میکند. تحلیلهای دادههای بزرگ در SNS آنلاین، روش تحلیلی محاسباتی ارائه شده را برای فهم روابط جامعه انسانی توسط نظریات و روشها بیان مینماید که شامل: ریاضیات، انفورماتیک، جامعه شناسی و یا علم مدیریت است و از آنها در سه بُعد: ساختار شبکه، تعامل گروهی و گسترش اطلاعات استفاده میکند. این برنامه، شامل تواناییهایی همچون: تحلیل هوش شبکه ای، بازاریابی اجتماعی، پشتیبانی تصمیم گیریهای دولتی و تحصیل آنلاین میباشد.

چالشهای کلان دادهها (Big Data)

کاربردهای متفاوت کلان داده ها، میتواند بر اساس این فناوریهای خلاقانه یا پلتفرم ها، توسعه یابند؛ اما در این میان، موانع بسیاری در راه توسعه کاربردها و برنامههای کلان دادهها وجود دارد که به قرار ذیل اند:

- نمایش داده ها: بسیاری از دادهها در نوع، ساختار، معناشناسی، دانه دانه بودن و قابلیت دسترسی، ناهمگن هستند. از این رو، نمایش دادههای ناهمگن، بر حجم دادهها تأثیر میگذارد و حتی مانع تحلیل مؤثر دادهها نیز میشود. ازاین رو، باید گفت: نمایش دادههای مناسب و همگن، باید بر ساختار، کلاس، نوع و همچنین فناوریهای یکپارچه دادهها تأثیرگذار باشد؛ به طوری که عملیات کارآمدسازی را در مجموعه دادههای مختلف مقدور سازد.

- کاهش افزونگی و فشرده سازی داده ها : عموماً، دادهها دارای یک سطح بالایی از افزونگی هستند. کاهش افزونگی و فشرده سازی داده ها، برای کاهش هزینه غیرمستقیم در کلّ سیستم مؤثر است؛ برای مثال، بیشتر دادههایی که با شبکههای حسگر تولید میشوند، به شدت افزونه دارند که میتوانند فیلتر شده، به ترتیب بزرگی فشرده شوند.

- مکانیزم تحلیلی: سیستم تحلیلی کلان دادهها باید تودههایی از دادههای ناهمگن را در یک زمان محدود پردازش نمایند. سیستم مدیریت پایگاه داده رابطهای یا RDBMS، غیرقابل گسترش طراحی شدند؛ اما پایگاه داده غیررابطهای، مزیتهای منحصر به فردی را در پردازش دادههای ساختاربندی شده نشان داده است.

- محرمانگی داده ها: صاحبان کلانداده ها، در حال حاضر نمیتوانند چنین مجموعه دادهای بزرگی را به دلیل ظرفیت محدودشان تحلیل کنند. آنها باید به حرفه ایها و ابزارهای پیشرفته برای تحلیل چنین دادههایی متکی باشند که خطرات بالقوهای را افزایش میدهد و امنیت دادهها را مخدوش میکند.

- مدیریت انرژی: مصرف انرژی سیستم محاسباتی یک پردازنده، از نظر اقتصادی بسیار مهم است. با افزایش حجم دادهها و تقاضاهای تحلیلی، پردازش، ذخیره سازی و انتقال دادههای بزرگ، به ناچار انرژی الکتریکی بسیاری مصرف میشود. از این رو، کنترل مصرف برق سیستم باید برای دادههای بزرگ انجام شود تا قدرت گسترش و قابلیت دسترسی، تضمین شود.

- همکاری و تعاون: یک معماری شبکه دادههای بزرگ و جامع، باید برای کمک به پژوهشگران و مهندسان در زمینههای مختلف ایجاد شود که بتوانند به انوع مختلفی از دادهها دسترسی پیدا کرده، از اطلاعات و دانش خودشان استفاده کنند؛ به طوری که برای تکمیل اهداف تحلیلی با یکدیگر همکاری نمایند.